Kurzfassung (für Eilige)

PostgreSQL ist längst mehr als „die SQL-Datenbank”. Dank Erweiterungen (Extensions) kann Postgres heute Suche, Geodaten, Zeitreihen, Vektorsuche (AI), Events/Queues und Analytics – in einem System. Technisch hat Postgres vieles aufgeholt, was früher als Domäne von Spezialdatenbanken (z. B. MongoDB) galt. Die Roadmap setzt den Kurs fort: bessere JSON-Funktionen, Replikation, Performance.

Einleitung

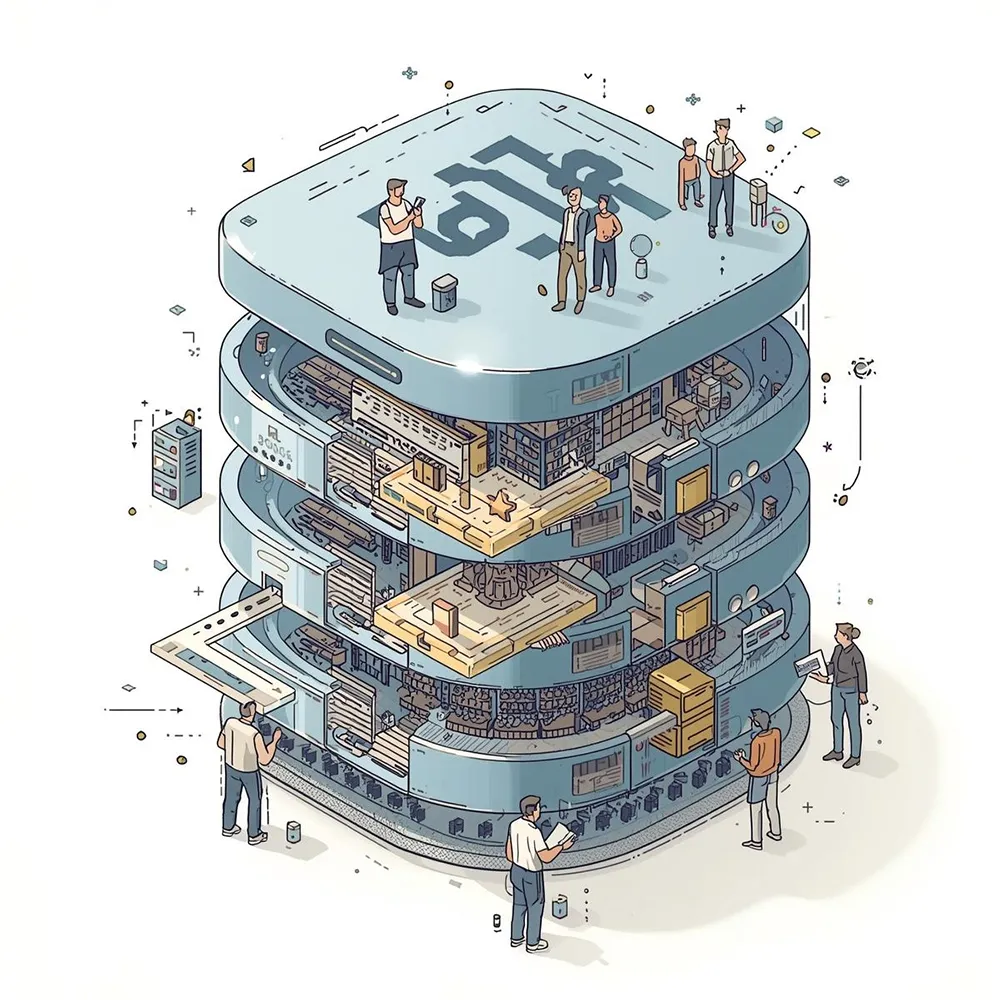

Für viele stand „PostgreSQL = Tabellen + SQL”. Heute ist Postgres eher wie ein Betriebssystem für Daten: Man startet mit relationalen Tabellen – und schaltet nach Bedarf Module frei (Erweiterungen), die neue Fähigkeiten hinzufügen. Das reduziert Komplexität: Weniger Produkte, weniger Integrationsfehler, einheitliches Operations-Modell.

Kurzer historischer Abriss

PostgreSQL geht auf das POSTGRES-Projekt (ab 1986, UC Berkeley, Michael Stonebraker) zurück. 1996 entstand der heutige Name „PostgreSQL”. Von Anfang an war das System darauf ausgelegt, neue Datentypen und Regeln zu unterstützen – der Extensibility-Gedanke steckt tief in der DNA.

Der Wandel zur Plattform

JSONB – Dokumente in der SQL-Welt

Was ist das? JSONB speichert JSON dokumentenorientiert, aber in einer Form, die indizierbar und abfragbar ist (z. B. GIN-Index).

Warum wichtig? Viele Anwendungen mischen strukturierte Daten (Tabellen) mit halbstrukturierten Daten (Events, Profile, Settings). Statt zwei Systeme zu betreiben, erledigt Postgres beides.

Pragmatischer Effekt: Entwickler behalten SQL als gemeinsame Sprache; Operationsteams behalten ein Monitoring/Backup.

Praktisches Beispiel:

-- Produkte mit strukturierten und flexiblen Daten

CREATE TABLE products (

id SERIAL PRIMARY KEY,

name TEXT NOT NULL,

price DECIMAL(10,2),

metadata JSONB

);

-- GIN-Index für schnelle JSON-Abfragen

CREATE INDEX idx_metadata ON products USING GIN (metadata);

-- Beispieldaten

INSERT INTO products (name, price, metadata) VALUES

('Laptop Pro', 1299.99, '{"country": "DE", "specs": {"cpu": "Intel i7", "ram": "16GB"}}'),

('Tablet Air', 599.99, '{"country": "AT", "specs": {"cpu": "Apple M1", "storage": "256GB"}}');

-- Abfrage: Alle Produkte für den deutschen Markt

SELECT name, price

FROM products

WHERE metadata @> '{"country": "DE"}';

-- Verschachtelte Abfragen auf JSON-Pfade

SELECT name, metadata->'specs'->>'cpu' as cpu

FROM products

WHERE metadata->'specs'->>'cpu' LIKE '%Intel%';

-- JSON als Tabelle (seit PG 17)

SELECT p.name, specs.*

FROM products p,

JSON_TABLE(p.metadata, '$.specs'

COLUMNS(cpu TEXT, ram TEXT, storage TEXT)) AS specs;Performance-Tipp: Der @> Operator (“contains”) nutzt den GIN-Index optimal. Für einzelne Schlüssel kann auch ein Expression-Index sinnvoll sein:

CREATE INDEX idx_country ON products ((metadata->>'country'));Fakten: JSON gibt es seit 9.2 (2012), JSONB seit 9.4 (2014); neuere Releases erweitern die SQL/JSON-Funktionen (z. B. JSON_TABLE in PG 17).

Volltextsuche – „eingebaute Mini-Suchmaschine”

Was ist das? Postgres hat einen nativen FTS-Stack mit tsvector (aufbereiteter Dokumenttext), tsquery (Suchanfrage) und dem Match-Operator @@.

Wozu? Produktsuche, Wissensbasen, Blog-Suche – ohne externen Suchserver.

Vorteile: Relevanz-Ranking, Hervorhebungen, Sprach-Stemming; alles im selben System wie die Transaktionsdaten.

Praktisches Beispiel:

-- Blog-Artikel mit Volltextsuche

CREATE TABLE articles (

id SERIAL PRIMARY KEY,

title TEXT,

content TEXT,

search_vector tsvector GENERATED ALWAYS AS (

setweight(to_tsvector('german', COALESCE(title, '')), 'A') ||

setweight(to_tsvector('german', COALESCE(content, '')), 'B')

) STORED

);

-- GIN-Index für schnelle Suche

CREATE INDEX idx_search ON articles USING GIN (search_vector);

-- Suche mit Relevanz-Ranking

SELECT

title,

ts_rank(search_vector, query) AS rank,

ts_headline('german', content, query, 'MaxWords=20') AS snippet

FROM articles,

to_tsquery('german', 'PostgreSQL & Datenbank') AS query

WHERE search_vector @@ query

ORDER BY rank DESC

LIMIT 10;Wichtig: Die Gewichtung (setweight) macht Treffer im Titel relevanter als im Content. Für deutsche Texte das Config 'german' verwenden (Stemming: “Datenbanken” → “datenbank”).

PostGIS – Geodaten out of the box

Was ist das? Eine populäre Extension für Geometrien & Geografien (Punkte, Linien, Polygone, Raster).

Use-Cases: „Shops in 2 km Umkreis”, Routen, Geofencing, Heatmaps.

Warum Postgres? Man spart sich einen separaten GIS-Store – Abfragen, Indizes und Berechnungen laufen direkt in der DB.

Zeitreihen – Metriken, IoT & Monitoring

Wie funktioniert’s? Nativ kann Postgres partitionieren; Extensions wie TimescaleDB optimieren u. a. Kompression, Continuous Aggregates und Verwaltung großer, zeitbasierter Tabellen.

Effekt: Logs, Sensorwerte, Metriken – effizient speichern und analytisch abfragen, ohne Daten in ein anderes System zu kippen.

Vektorsuche (AI) – Embeddings speichern & finden

Was ist das? Mit pgvector speichert Postgres Vektoren (z. B. Embeddings aus LLMs) und findet „ähnliche” Einträge (Nearest Neighbor).

Indexe: u. a. HNSW oder IVFFlat; je nach Bedarf „genau” oder „schnell & approximativ”.

Praxis: RAG-Suche (Retrieval Augmented Generation), Empfehlungen, semantische Duplikatsuche – ohne separate Vektor-DB.

RAG-Beispiel (Wissensdatenbank für LLMs):

-- pgvector Extension aktivieren

CREATE EXTENSION vector;

-- Dokumente mit Embeddings (z.B. von OpenAI ada-002: 1536 Dimensionen)

CREATE TABLE documents (

id SERIAL PRIMARY KEY,

title TEXT,

content TEXT,

embedding vector(1536)

);

-- HNSW-Index für schnelle Approximate Nearest Neighbor Suche

CREATE INDEX ON documents

USING hnsw (embedding vector_cosine_ops);

-- Ähnliche Dokumente finden (Cosine Similarity)

SELECT

title,

1 - (embedding <=> query_embedding) AS similarity

FROM documents

ORDER BY embedding <=> query_embedding

LIMIT 5;

-- Hybrid-Suche: Vektor + Keywords kombinieren

SELECT

title,

1 - (embedding <=> query_embedding) AS vector_score,

ts_rank(search_vector, to_tsquery('german', 'PostgreSQL')) AS text_score

FROM documents

WHERE search_vector @@ to_tsquery('german', 'PostgreSQL')

ORDER BY (vector_score * 0.7 + text_score * 0.3) DESC

LIMIT 10;Anwendungsfälle in der Praxis:

- RAG-Systeme: Relevante Dokumente für LLM-Kontext finden

- Semantische Suche: “günstiges Notebook” findet auch “preiswerter Laptop”

- Duplikatserkennung: Ähnliche Support-Tickets automatisch gruppieren

- Empfehlungssysteme: “Kunden, die X kauften, interessierten sich auch für…”

Index-Wahl:

- HNSW: Schneller, höherer Speicher (Standard für Production)

- IVFFlat: Weniger Speicher, etwas langsamer (gut für Prototyping)

Performance-Tipp: Bei Millionen Vektoren HNSW mit m=16, ef_construction=64 tunen.

Events & Queues – Postgres als „Nervensystem”

Was ist das? Per LISTEN/NOTIFY lassen sich Pub/Sub-Signale verschicken; das Outbox-Pattern sorgt für zuverlässige Event-Weitergabe. Mit Extensions wie pgmq wird Postgres sogar zur haltbaren Queue.

Warum das zählt: Statt Kafka/RabbitMQ + Postgres zu betreiben, reicht in vielen Fällen ein System – konsistent und transaktional.

Hinweis: Für extreme Durchsatzspitzen bleibt ein dedizierter Broker weiterhin sinnvoll.

„Scale-out”, wenn nötig – Citus (Distributed Postgres)

Was ist das? Citus verteilt Tabellen auf Knoten („Shards”) und parallelisiert Abfragen/Transaktionen; als Managed-Service u. a. in Azure Cosmos DB for PostgreSQL.

Wozu? Wenn ein einzelner Server nicht mehr reicht (sehr viele Nutzer, sehr viele Daten), kann Postgres horizontal skalieren – ohne Technologiebruch.

Postgres vs. MongoDB – Vor-/Nachteile & wo Postgres aufgeholt hat

Einfaches Bild:

- MongoDB = Dokumente zuerst, Schema optional; horizontales Skalieren fest eingebaut

- PostgreSQL = Relationen zuerst, heute aber mit sehr starken Dokument-/JSON-, Such-, Geo-, Zeitreihen- und AI-Fähigkeiten – plus Optionen für Scale-out

Datenmodell & Sprache

MongoDB: Dokument-/JSON-Datenmodell, Abfragen über die Aggregation Pipeline; Schemafreiheit ist Standard.

Postgres: Relational + JSONB. Man kann streng (Tabellen & Constraints) und flexibel (JSONB-Felder) arbeiten – beides in einer Abfrage, mit SQL als einheitlicher Sprache.

Was hat Postgres aufgeholt? JSONB (inkl. Indexierung) macht viele frühere Mongo-Use-Cases nativ in Postgres möglich.

Transaktionen & Konsistenz

Historisch: Postgres hatte seit jeher ACID-Transaktionen über mehrere Tabellen hinweg.

MongoDB: führte Multi-Dokument-Transaktionen erst 2018 in 4.0 ein; 2019 (4.2) folgten verteilte Transaktionen auf Shards.

Bedeutung für Teams: Wer komplexe, konsistente Updates braucht (z. B. Buchungen, Geldtransfers), findet in beiden Systemen Lösungen; Postgres ist hier jedoch der „native” Veteran.

Skalierung

MongoDB: Auto-Sharding gehört zur Kern-DNA; großer Pluspunkt für lineares Wachstum.

Postgres: vertikal sehr stark (ein Knoten), horizontal via Citus (Sharding, parallele Abfragen) – als Open-Source-Extension und gemanagt in Azure Cosmos DB for PostgreSQL.

Praxis: Für 80 % der Anwendungen reicht oft vertikales Skalieren + Replikas. Wird’s riesig, ist Scale-out heute auch mit Postgres sauber möglich.

Ab Werk-Features vs. Erweiterbarkeit

MongoDB: Dokumentenfokus, Change Streams, eingebautes Sharding; Ökosystem um Atlas (Cloud).

Postgres: Erweiterbar wie kaum eine andere DB (PostGIS, pgvector, Timescale, FTS, Foreign Data Wrapper u. v. m.). Ein System, viele Fähigkeiten – oft weniger Infrastruktur.

Typische Entscheidungshilfen (einfach & praxisnah)

Wenn… ihr primär Dokumente speichert, sehr schemalos arbeitet und sofort horizontal sharden wollt → MongoDB fühlt sich „natürlicher” an.

Wenn… ihr transaktionale Workloads habt, SQL mögt, Reporting/Analytics braucht und zusätzliche Fähigkeiten (Suche, Geo, AI, Events) im selben System wollt → PostgreSQL ist extrem attraktiv.

Hybrid-Realität: Viele Teams landen bei Postgres, weil sie dort Flexibilität (JSONB) und Strenge (Constraints) sinnvoll kombinieren können – und Extensions den „Baukasten” liefern.

Aktuelle Änderungen & Roadmap (2024 → 2025)

PostgreSQL 17 (Sep 2024)

u. a. effizienteres VACUUM-Speichermanagement, neue SQL/JSON-Funktionen wie JSON_TABLE, Verbesserungen bei Logischer Replikation und Query-Planung.

PostgreSQL 18 (Beta, Sommer 2025)

Zweite Beta am 17. Juli 2025 veröffentlicht; zeigt die geplanten Features für 18 (Details können sich bis GA ändern). Schwerpunkt traditionell: Performance, Replikation, SQL-Erweiterungen & Betrieb/Observability.

Merke: Beta = Vorschau, nicht final.

Sicherheits- & Wartungsversionen (Aug 2025)

Laufende Minor-Releases pflegen 17/16/… und liefern Fixes, u. a. bei logischer Replikation.

Wann Postgres NICHT die beste Wahl ist

So vielseitig Postgres ist – es gibt Szenarien, wo Alternativen besser passen:

Extreme Write-Throughput bei lockeren Konsistenz-Anforderungen

- MongoDB oder Cassandra sind bei Millionen Writes/Sekunde mit eventual consistency oft performanter

- Beispiel: IoT-Sensor-Daten wo einzelne verlorene Datenpunkte unkritisch sind

Native Graph-Traversierung

- Für komplexe Graph-Analysen (“6 Degrees of Separation”, Fraud Detection mit tiefen Beziehungen) sind Neo4j oder TigerGraph spezialisierter

- Postgres mit

pg_graphqloder rekursiven CTEs kann einfache Graphen, ist aber kein nativer Graph-Store

Multi-Tenant mit strikter Isolation

- Wenn tausende Kunden jeweils eigene Datenbank-Instanzen brauchen, wird die Verwaltung komplex

- Cloud-native Multi-Tenant-Systeme wie MongoDB Atlas oder Fauna können hier einfacher sein

Sehr schemalose, hochdynamische Datenstrukturen

- Wenn wirklich jedes Dokument ein völlig anderes Schema hat und ihr null Constraints wollt, ist MongoDB direkter

- Postgres JSONB ist stark, aber das SQL-Denken bleibt präsent

Real-time Analytics auf massiven Datenmengen

- Für Petabyte-Scale Analytics mit Sub-Sekunden-Latenz sind ClickHouse, Apache Druid oder BigQuery gebaut

- Postgres mit TimescaleDB ist gut für TB-Bereich, darüber wird’s aufwendig

Fazit: Postgres ist die beste Wahl für 80% der Anwendungen. Bei extremen Spezialanforderungen prüft die Alternativen – aber unterschätzt nicht, wie viel Postgres heute abdeckt.

Managed Services & Betrieb

Self-Hosted vs. Managed – was passt?

Managed Services (empfohlen für die meisten Teams)

AWS RDS / Aurora PostgreSQL

- Automatische Backups, Patches, Multi-AZ

- Aurora: PostgreSQL-kompatibel mit besserer Performance/Skalierung

- Gut für: AWS-native Projekte

Azure Database for PostgreSQL / Cosmos DB for PostgreSQL (Citus)

- Flexible Server mit Zone-Redundanz

- Citus für horizontale Skalierung eingebaut

- Gut für: Azure-Ökosystem, Scale-out-Bedarf

Google Cloud SQL / AlloyDB

- AlloyDB: Google’s Postgres-Fork mit 4x schnelleren Analytics

- Cloud SQL: Standard Postgres, gut integriert

- Gut für: GCP-Projekte

Supabase

- Postgres + Auth + Storage + Realtime in einem

- Instant APIs, gut für schnelles Prototyping

- Gut für: Startups, moderne Webapps

Railway / Render / Fly.io

- Developer-freundlich, schnelles Setup

- Günstiger für kleine Projekte

- Gut für: Side-Projects, MVPs

Self-Hosted

Wann sinnvoll:

- Sehr spezifische Compliance-Anforderungen

- Volle Kontrolle über Hardware/Config nötig

- Bestehendes Ops-Team mit Postgres-Expertise

Tools für Self-Hosting:

- Patroni: HA-Cluster mit automatischem Failover

- pgBackRest: Enterprise Backup/Recovery

- pgBouncer: Connection Pooling

- Prometheus + postgres_exporter: Monitoring

Kostenfaktor: Managed Services kosten 2-3x mehr als reine Compute/Storage, sparen aber Operations-Zeit. Für Teams < 5 Entwickler fast immer günstiger.

Warum das wichtig ist

PostgreSQL ist nicht mehr „nur” die relationale Datenbank. Dank Extensions wird es zur Plattform, die viele Spezialwerkzeuge ersetzt – mit SQL als rotem Faden.

Im Vergleich zu MongoDB hat Postgres bei JSON/Dokumenten, Suche, Geo, Zeitreihen und AI/Vektoren stark aufgeholt. Wer einfacher betreiben, konsistenter entwickeln und später skalieren möchte, ist mit Postgres heute hervorragend bedient.

Die wichtigsten Vorteile auf einen Blick:

- Ein System für viele Use-Cases (weniger Komplexität)

- SQL als einheitliche Sprache (weniger Lernkurve)

- Bewährte ACID-Eigenschaften (seit Jahrzehnten)

- Starkes Extension-Ökosystem (flexibel erweiterbar)

- Aktive Entwicklung (moderne Features, Performance)

- Reife Managed Services (weniger Betriebsaufwand)